Los procesos de Markov fueron desarrollados por científicos en 1907. Los principales matemáticos de la época desarrollaron esta teoría, algunos de ellos todavía la están mejorando. Este sistema se extiende también a otros campos científicos. Las prácticas cadenas de Markov se utilizan en diversas áreas donde una persona necesita llegar en un estado de expectativa. Pero para comprender claramente el sistema, debe tener conocimiento de los términos y disposiciones. Se considera que la aleatoriedad es el factor principal que determina el proceso de Markov. Es cierto que no es similar al concepto de incertidumbre. Tiene ciertas condiciones y variables.

Características del factor de aleatoriedad

Esta condición está sujeta a la estabilidad estática, más precisamente, a sus regularidades, que no se tienen en cuenta en caso de incertidumbre. A su vez, este criterio permite el uso de métodos matemáticos en la teoría de los procesos de Markov, como lo señaló un científico que estudió la dinámica de las probabilidades. El trabajo que creó trató directamente con estas variables. A su vez, el proceso aleatorio estudiado y desarrollado, que tiene los conceptos de estado ytransición, así como también se utiliza en problemas estocásticos y matemáticos, al tiempo que permite que estos modelos funcionen. Entre otras cosas, brinda la oportunidad de mejorar otras importantes ciencias teóricas y prácticas aplicadas:

- teoría de la difusión;

- teoría de colas;

- teoría de la fiabilidad y otras cosas;

- química;

- física;

- mecánica.

Características esenciales de un factor no planificado

Este proceso de Markov está dirigido por una función aleatoria, es decir, cualquier valor del argumento se considera un valor dado o uno que toma una forma preparada previamente. Ejemplos son:

- oscilaciones en el circuito;

- velocidad de movimiento;

- rugosidad de la superficie en un área determinada.

También se cree comúnmente que el tiempo es un hecho de una función aleatoria, es decir, se produce una indexación. Una clasificación tiene la forma de un estado y un argumento. Este proceso puede ser con estados o tiempos tanto discretos como continuos. Además, los casos son diferentes: todo sucede de una u otra forma, o simultáneamente.

Análisis detallado del concepto de aleatoriedad

Fue bastante difícil construir un modelo matemático con los indicadores de desempeño necesarios en una forma claramente analítica. En el futuro, fue posible realizar esta tarea, porque surgió un proceso aleatorio de Markov. Analizando este concepto en detalle, es necesario derivar un cierto teorema. Un proceso de Markov es un sistema físico que ha cambiado suposición y condición que no ha sido preprogramada. Por lo tanto, resulta que en él tiene lugar un proceso aleatorio. Por ejemplo: una órbita espacial y una nave que se lanza a ella. El resultado se logró solo debido a algunas imprecisiones y ajustes, sin los cuales no se implementa el modo especificado. La mayoría de los procesos en curso son inherentes a la aleatoriedad, la incertidumbre.

En cuanto al fondo, casi cualquier opción que se pueda considerar estará sujeta a este factor. Un avión, un dispositivo técnico, un comedor, un reloj: todo esto está sujeto a cambios aleatorios. Además, esta función es inherente a cualquier proceso en curso en el mundo real. Sin embargo, siempre que esto no se aplique a los parámetros ajustados individualmente, las perturbaciones que se produzcan se percibirán como deterministas.

El concepto de un proceso estocástico de Markov

Al diseñar cualquier dispositivo técnico o mecánico, el dispositivo obliga al creador a tener en cuenta varios factores, en particular, las incertidumbres. El cálculo de fluctuaciones y perturbaciones aleatorias surge en el momento de interés personal, por ejemplo, al implementar un piloto automático. Algunos de los procesos que se estudian en ciencias como la física y la mecánica son.

Pero prestarles atención y realizar una investigación rigurosa debe comenzar en el momento en que se necesita directamente. Un proceso aleatorio de Markov tiene la siguiente definición: la característica de probabilidad de la forma futura depende del estado en el que se encuentre en un momento dado, y no tiene nada que ver con el aspecto del sistema. tan dadoel concepto indica que se puede predecir el resultado, considerando solo la probabilidad y olvidándose del fondo.

Explicación detallada del concepto

En este momento, el sistema se encuentra en cierto estado, se está moviendo y cambiando, es básicamente imposible predecir lo que sucederá a continuación. Pero, dada la probabilidad, podemos decir que el proceso se completará de cierta forma o conservará la anterior. Es decir, el futuro surge del presente, olvidándose del pasado. Cuando un sistema o proceso entra en un nuevo estado, normalmente se omite el historial. La probabilidad juega un papel importante en los procesos de Markov.

Por ejemplo, el contador Geiger muestra el número de partículas, que depende de un determinado indicador, y no del momento exacto en que se produjo. Aquí el criterio principal es el anterior. En la aplicación práctica, no solo se pueden considerar los procesos de Markov, sino también otros similares, por ejemplo: los aviones participan en la batalla del sistema, cada uno de los cuales se indica con algún color. En este caso, el criterio principal nuevamente es la probabilidad. Se desconoce en qué punto ocurrirá la preponderancia en números y para qué color. Es decir, este factor depende del estado del sistema y no de la secuencia de muertes de aeronaves.

Análisis estructural de procesos

Un proceso de Markov es cualquier estado de un sistema sin una consecuencia probabilística y sin tener en cuenta la historia. Es decir, si incluyes el futuro en el presente y omites el pasado. La sobresaturación de este tiempo con la prehistoria conducirá a la multidimensionalidad ymostrará construcciones complejas de circuitos. Por lo tanto, es mejor estudiar estos sistemas con circuitos simples con parámetros numéricos mínimos. En consecuencia, estas variables se consideran determinantes y condicionadas por algunos factores.

Un ejemplo de procesos de Markov: un dispositivo técnico en funcionamiento que se encuentra en buenas condiciones en este momento. En este estado de cosas, lo que interesa es la probabilidad de que el dispositivo funcione durante un período de tiempo prolongado. Pero si percibimos el equipo como depurado, entonces esta opción ya no pertenecerá al proceso en consideración debido a que no hay información sobre cuánto tiempo funcionó el dispositivo antes y si se realizaron reparaciones. Sin embargo, si estas dos variables de tiempo se complementan e incluyen en el sistema, entonces su estado se puede atribuir a Markov.

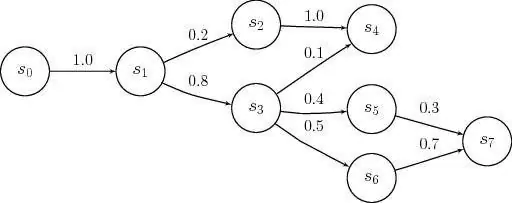

Descripción del estado discreto y continuidad del tiempo

Los modelos de procesos de Markov se aplican en el momento en que es necesario descuidar la prehistoria. Para la investigación en la práctica, los estados continuos discretos se encuentran con mayor frecuencia. Ejemplos de tal situación son: la estructura del equipo incluye nodos que pueden fallar durante las horas de trabajo, y esto sucede como una acción aleatoria no planificada. Como resultado, el estado del sistema pasa por la reparación de uno u otro elemento, en este momento uno de ellos estará sano o ambos estarán depurados, o viceversa, están completamente ajustados.

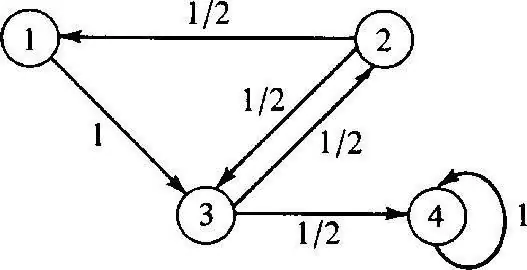

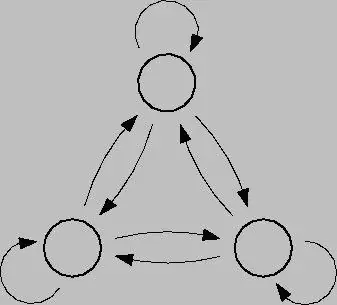

El proceso discreto de Markov se basa en la teoría de la probabilidad y también estransición del sistema de un estado a otro. Además, este factor ocurre instantáneamente, incluso si ocurren averías accidentales y trabajos de reparación. Para analizar tal proceso, es mejor usar gráficos de estado, es decir, diagramas geométricos. Los estados del sistema en este caso se indican mediante varias formas: triángulos, rectángulos, puntos, flechas.

Modelado de este proceso

Los procesos de Markov de estado discreto son posibles modificaciones de sistemas como resultado de una transición instantánea, y que pueden numerarse. Por ejemplo, puede construir un gráfico de estado a partir de flechas para nodos, donde cada uno indicará la ruta de los factores de falla dirigidos de manera diferente, el estado operativo, etc. En el futuro, pueden surgir preguntas: como el hecho de que no todos los elementos geométricos apuntan en la dirección correcta, porque en el proceso, cada nodo puede deteriorarse. A la hora de trabajar, es importante tener en cuenta los cierres.

El proceso de Markov en tiempo continuo se produce cuando los datos no están prefijados, sucede de forma aleatoria. Las transiciones no fueron planificadas previamente y ocurren a s altos, en cualquier momento. En este caso, nuevamente, el papel principal lo juega la probabilidad. Sin embargo, si la situación actual es una de las anteriores, se requerirá un modelo matemático para describirla, pero es importante comprender la teoría de la posibilidad.

Teorías probabilísticas

Estas teorías se consideran probabilísticas, teniendo rasgos característicos comoorden aleatorio, movimiento y factores, problemas matemáticos, no deterministas, que son ciertos de vez en cuando. Un proceso de Markov controlado tiene y se basa en un factor de oportunidad. Además, este sistema puede cambiar a cualquier estado instantáneamente en varias condiciones e intervalos de tiempo.

Para llevar esta teoría a la práctica, es necesario tener un conocimiento importante de probabilidad y su aplicación. En la mayoría de los casos, uno está en un estado de expectativa, que en un sentido general es la teoría en cuestión.

Ejemplos de la teoría de la probabilidad

Ejemplos de procesos de Markov en esta situación pueden ser:

- café;

- taquillas;

- talleres de reparación;

- estaciones para diversos fines, etc.

Como regla general, la gente trata con este sistema todos los días, hoy se llama hacer cola. En las instalaciones donde existe dicho servicio, es posible exigir varias solicitudes, que se satisfacen en el proceso.

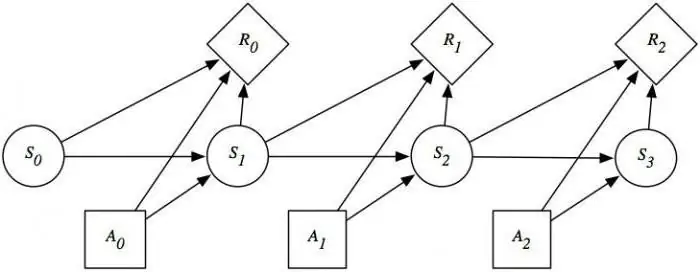

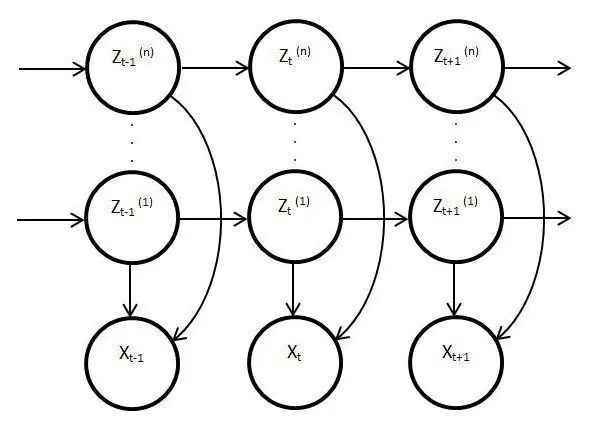

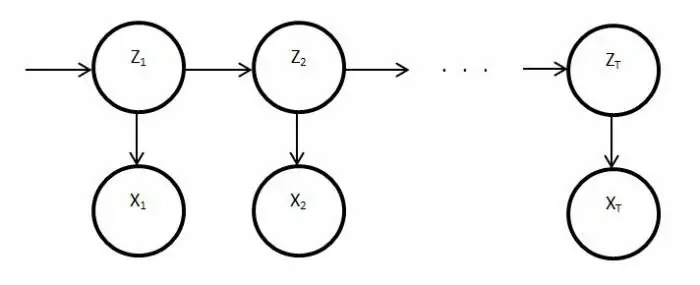

Modelos de procesos ocultos

Dichos modelos son estáticos y copian el trabajo del proceso original. En este caso, la característica principal es la función de monitorear parámetros desconocidos que deben ser desentrañados. Como resultado, estos elementos se pueden utilizar en el análisis, la práctica o para reconocer varios objetos. Los procesos ordinarios de Markov se basan en transiciones visibles y en probabilidad, solo se observan incógnitas en el modelo latentevariables afectadas por el estado.

Divulgación esencial de los modelos ocultos de Markov

También tiene una distribución de probabilidad entre otros valores, como resultado, el investigador verá una secuencia de caracteres y estados. Cada acción tiene una distribución de probabilidad entre otros valores, por lo que el modelo latente proporciona información sobre los estados sucesivos generados. Las primeras notas y referencias a los mismos aparecieron a finales de los años sesenta del siglo pasado.

Luego se usaron para el reconocimiento de voz y como analizadores de datos biológicos. Además, los modelos latentes se han difundido en escritura, movimientos, informática. Además, estos elementos imitan el trabajo del proceso principal y permanecen estáticos, sin embargo, a pesar de esto, hay características mucho más distintivas. En particular, este hecho se refiere a la observación directa y la generación de secuencias.

Proceso de Markov estacionario

Esta condición existe para una función de transición homogénea, así como para una distribución estacionaria, que se considera la principal y, por definición, una acción aleatoria. El espacio de fase para este proceso es un conjunto finito, pero en este estado de cosas, la diferenciación inicial siempre existe. Las probabilidades de transición en este proceso se consideran bajo condiciones de tiempo o elementos adicionales.

El estudio detallado de los modelos y procesos de Markov revela el problema de satisfacer el equilibrio en varias áreas de la viday actividades de la sociedad. Dado que esta industria afecta la ciencia y los servicios masivos, la situación se puede corregir analizando y prediciendo el resultado de cualquier evento o acción de los mismos relojes o equipos defectuosos. Para aprovechar al máximo las capacidades del proceso de Markov, vale la pena comprenderlas en detalle. Después de todo, este dispositivo ha encontrado una amplia aplicación no solo en la ciencia, sino también en los juegos. Este sistema en su forma pura generalmente no se considera, y si se usa, solo sobre la base de los modelos y esquemas anteriores.